Dans une époque où nous sommes de plus en plus entourés par des appareils, des applications, chatbots, assistants virtuels, robots, il est devenu indispensable que ces machines puissent communiquer des émotions pour que nos relations avec elles soient optimales. En effet, les émotions conduisent chaque aspect de notre existence : notre bien-être, notre santé, nos relations avec les autres et nos prises de décision sont dépendants de notre état émotionnel. Les personnes dotées d’une haute intelligence émotionnelle peuvent construire de meilleures relations avec les autres, sont plus fiables et plus convaincantes. Dans le domaine du marketing par exemple, l’émotion (représentée par l’avis des clients) exerce une influence stratégique qui pourrait déterminer la réputation d’un produit, d’un service, ou d’une marque. Mais détecter et interpréter l’énorme quantité de données disponibles sur Internet rend cette tâche impossible par une approche exclusivement humaine. L’intégration d’une dimension émotionnelle à l’Intelligence Artificielle est devenue une exigence dans l’interaction Homme-Machine. Cette approche a donné naissance à un nouveau champ de recherche : L’intelligence artificielle émotionnelle (IAE), une liaison entre l’intelligence artificielle (IA) et l’intelligence émotionnelle (IE), Sa tâche essentielle consiste à comprendre, modéliser et reproduire les émotions humaines.

La définition de l’IAE et l’émergence de ce domaine

L’intelligence artificielle émotionnelle (IAE) désigne l’étude et le développement des systèmes d’appareils capables de reconnaître, d’exprimer, de synthétiser et de modéliser les sentiments et les émotions humaines. C’est un autre terme de « l’informatique affective » ou « Affecting Computing » ; une branche des sciences interdisciplinaires, qui couvre la psychologie, les neurosciences, la sociologie et les sciences cognitives.

La base de cette discipline a émergé avec l’essor des théories sur les émotions au 19e siècle, telle que la théorie dite ‘périphérique’ de James-Lange (1884), selon laquelle les émotions résultent d’une modification Physiologique dans le corps humain[i]. Le concept moderne d’informatique affective a été décrit pour la première fois dans les travaux de Rosalind Picard en 1995[ii], qui ont représenté un véritable bouleversement dans l’IA ainsi que dans le champ de l’interaction Homme-Machine (IHM). Son idée porte sur la possibilité de créer des machines qui se réfèrent à, résultent de ou influencent délibérément les émotions humaines. Selon elle, l’Informatique affective est la capacité d’un ordinateur à reconnaître, exprimer et répondre intelligemment à l’émotion de l’homme. Il y a plein de raisons qui motivent la naissance de l’IAE, dans leurs travaux, Reeves et Nass ont affirmé que la nature humaine tend à interagir avec les ordinateurs comme si ces derniers étaient capables de comprendre les émotions (Reeves et Nass, 1998)[iii]. De même, Covey[iv], a démontré que pendant l’interaction homme–machine, l’homme a une tendance à supposer que l’ordinateur a une capacité émotionnelle. En effet Covey note que plus la machine ressemble dans sa fonctionnalité à l’homme (par exemple un robot par rapport à un une interface textuelle ou un avatar) plus l’homme va percevoir le comportement de cette machine aussi intelligente que émotionnelle. Dans son livre « The Emotion Machine » publié en 2006, Marvin Minsky (un des organisateurs de la conférence de Dartmouth qui s’est tenue à l’été 1956 et qui donna naissance au terme d’intelligence artificielle) a aussi indiqué le rôle central des émotions dans le raisonnement. Selon lui les émotions sont une façon différente de penser, que notre esprit utilise pour augmenter notre intelligence. Ainsi selon lui, l’intelligence artificielle ne sera capable d’un véritable raisonnement qu’une fois qu’elle aura compris les émotions[v].

Comment l’IAE sera-t-elle avantageuse ?

L’intelligence artificielle, dans plusieurs aspects de nos vies, a simplifié de plus en plus nos tâches. Des machines et des robots sont déjà utilisés en services de fabrication et de production dans des entreprises. De plus, l’intelligence artificielle change les règles du jeu dans des domaines fondamentaux tels que l’aviation, l’éducation, le marketing, la finance, les industries lourdes, la médecine, les médias et le service à la clientèle. En effet, les technologies dans les domaines ci-mentionnés s’améliorent de manière progressive afin de répondre aux exigences des clients qui évoluent constamment. L’IAE sera très bénéfique pour améliorer les services de vente et les services à la clientèle pour les entreprises. Des chatbots et des applications mobiles sont déjà capables de reconnaître et de réagir efficacement aux expressions émotionnelles des personnes telles que la colère, la déception et l’irritation, améliorant ainsi l’expérience client. L’intelligence artificielle émotionnelle sera également utilisée pour améliorer la productivité de travail, aider les médecins et les infirmières en matière de soins et de santé, et personnaliser l’expérience d’apprentissage pour les étudiants. Bien évidemment, les machines ne peuvent pas précisément comprendre et traiter nos émotions comme le fait l’homme, mais elles peuvent les détecter à partir de signaux issus de nos conversations, de nos expressions et de notre manière de parler. C’est là où l’intelligence artificielle émotionnelle doit intervenir[vi].

Les technologies d’informatique affective peuvent détecter l’état émotionnel et capter les différentes expressions humaines (faciale, vocale et textuelle) d’un utilisateur, via des capteurs, des microphones, des caméras et / ou des logicielles et réagissent en exécutant des fonctionnalités spécifiques et prédéfinies d’un produit / service, telles que la modification d’un questionnaire ou la recommandation d’un ensemble de vidéos en fonction de l’ambiance de l’apprenant.[vii]

Répétition, humanisation et détection des expressions vocales :

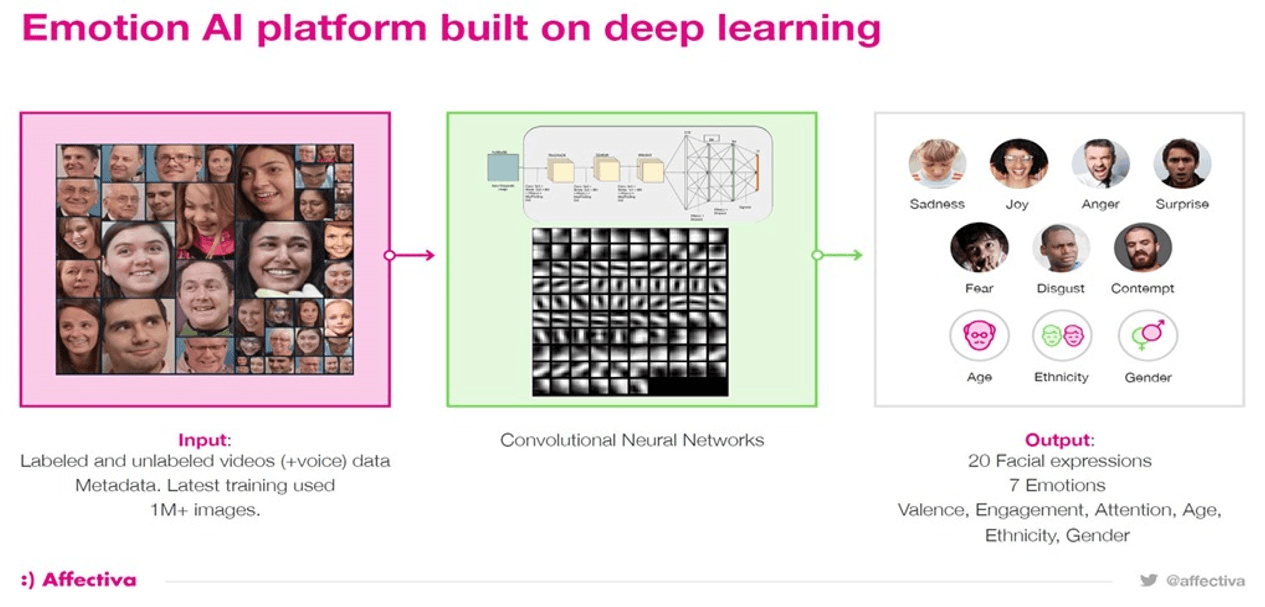

La capacité de générer une parole au son naturel constitue depuis longtemps un défi pour les logiciels qui transforment le texte en paroles. Les assistants personnels tels que Siri (pour iPhone), Alexa (l’assistant personnel virtuel d’Amazon) et Google Assistant utilisent tous les logiciels text-to-speech afin de créer une interface plus pratique avec leurs utilisateurs. Ces systèmes fonctionnent à partir de fichiers vocaux préenregistrés. Cependant, l’humanisation de la voix d’un individu en intégrant des émotions (tel que l’intonation dans la communication vocale) est relativement nouveau. Les systèmes de reconnaissance vocale peuvent détecter les émotions humaines par l’intonation, les pauses, etc., de la même manière que nous détectons les changements d’humeur émotionnelle d’un proche, ami ou un collègue de travail. Par exemple, une société canadienne appelée Lyrebird [viii] a créé un système d’IA qui imite la voix d’une personne en analysant les enregistrements de la parole et les transcriptions textuelles correspondantes. Le logiciel de Lyrebird peut, en écoutant longuement l’audio parlé, générer des phrases complètement nouvelles qui incluent différentes intonations et émotions pour chaque voix. De même, la startup Américaine Affectiva utilise des nouvelles technologies qui observent les changements dans la paralinguistique de speach, la tonalité, le volume, le rythme et la qualité de la voix pour distinguer les émotions et le genre de la personne qui parle. Cette technique va permettre le développement d’applications et de périphériques sensibles aux émotions, en temps réel. [ix]

Détection des expressions corporelles et faciales:

Des chercheurs ont récemment mis au point une plateforme utilisant le ‘deep learning’, qui permet de déterminer si une personne est un criminel en examinant simplement ses traits du visage, ce logiciel avait un taux d’exactitude de 90%.[x] En 2016, la société Apple a acheté une start-up qui a créé un logiciel capable de lire les expressions faciales – appelé Emotient. Ce dernier pourrait être utilisé dans les grands magasins, à l’aide d’une caméra de vidéosurveillance il pourrait détecter la pensée d’un client à partir de son body language ou des expressions de son visage[xi]. Le start-up Affectiva a aussi développé un algorithme de deep-learning capable de déduire un état émotionnel à partir d’une attitude physique. Il utilise une webcam qui traque les sourires et les froncements de sourcils d’un utilisateur afin de détecter le niveau de surprise, de plaisir ou de confusion de l’utilisateur. Le logiciel est conçu pour s’adapter aux spécificités de chacun de sorte qu’il puisse couvrir tous les cas de figure, par exemple le logiciel peut distinguer un sourire japonais de celui d’un brésilien[xii].

Affectiva utilise également des webcams pour mesurer la fréquence cardiaque d’une personne sans porter un capteur. En suivant les changements de couleur du visage de cette personne, la webcam pulse à chaque fois que le cœur bat. L’IAE sera aussi présente dans la technologie des voitures autonomes. La société japonaise Honda s’est lancée en 2016 dans une nouvelle approche de la mobilité urbaine : faire de la voiture autonome une voiture émotionnelle. Son nom est NeuV, elle est Petite, carrée, au design épuré, la voiture étant la première équipée d’un système d’intelligence artificielle appelée ‘Emotion Engine’ développé par Cocoro SB. Une technologie qui permettrait à la voiture de réagir aux conversations et aux émotions des passagers afin de prendre de meilleures décisions dans la gestion et la conduite du véhicule.[xiii]

La future de l’IA émotionnelle

L’idée que les émotions humaines ne peuvent pas être reproduites par des machines fonctionnant de manière logique n’est plus justifiée. Dans son livre intitulé Homo Deus A Brief History of Tomorrow, Yuval Noah Harari affirme que les humains sont principalement un ensemble d’algorithmes biologiques façonnés au cours de millions d’années d’évolution[xiv]. L’utilisation des programmes d’IA pour détecter les émotions humaines présente plusieurs avantages potentiels. Ils ne sont pas payés, ils ne fatiguent jamais et peuvent fonctionner 24 sur 24 heures en prenant des décisions cohérentes.

Le potentiel du marché de l’informatique affective est énorme :

Selon le rapport de TechSci Research, «Global Affective Computing Market», le marché mondial de l’informatique affective devrait connaître un taux de croissance annuel composé (CAGR) de 27,47%, en termes de valeur, au cours de la période 2017-2022.

Le graphique présente la taille de marché globale de l’informatique affective (2012-2022) par industrie. Ce rapport rapport estime que les applications IAE seront utilisées plus dans le domaine des études de marché, bien que le domaine de media & publicité se classe en deuxième place en tant qu’utilisateur final.

En 2016, les solutions de détection des expressions faciales ont dominé le marché, en raison de leur capacité à cartographier les expressions des utilisateurs et à les analyser en temps réel. Toutefois, au cours des années prochaines, les solutions de reconnaissance physiologique devraient dépasser les autres solutions dans le marché de l’informatique affective.

Le rapport également indique que l’utilisation croissante de dispositifs portables (smart wearable devices), le déploiement de solutions d’IAE par la plupart des entreprises afin de cibler des audiences, associés à un nombre croissant de startup, sont les facteurs clés qui vont conduire le marché mondial de l’informatique affective au cours des années suivantes. En outre, le rôle croissant des robots sociaux, intégrés avec des solutions émotionnelles, dans le secteur de la santé devrait stimuler la demande en informatique affective, dans le monde entier, jusqu’en 2022.[xv]

Géographiquement, le marché de l’informatique affective couvre des régions telles que l’Asie-Pacifique, l’Europe, l’Amérique du Nord et le reste du monde. Le marché de l’Amérique de nord est estimé avoir la part de marché la plus importante jusqu’à 2026, grâce à la forte présence d’un grand nombre d’entreprises et d’infrastructures. Toutefois, l’Asie-Pacifique devrait afficher le taux de croissance (CAGR) le plus élevé au cours de la période de prévision, en raison de la forte demande d’appareils et smartphones dans cette région.[xvi]

En outre, le marché européen devrait afficher le taux de croissance annuel composé (CAGR) le plus rapide, en raison de la tendance croissante des entreprises européennes à reconnaitre le comportement des clients afin d’en tirer davantage des perspectives commerciales.[xvii]

Les entreprises qui seront capables d’intégrer efficacement l’interprétation contextuelle et l’émotion dans leurs technologies deviendront sans doute des pionniers dans ce marché. Cependant, il est important que ces entreprises prennent en considération les implications sociales et étiques d’une telle transition. Le grand défi ne sera pas donc la mise au point de modèles plus efficaces d’intelligence artificielle émotionnelle, mais le fait de trouver des humains émotionnellement intelligents pour les construire.

Par Nivine Albouz, promotion 2018-2019 du M2 IESCI

Bibliographie

[i] G.Coppin, D. Sander. Théories et concepts contemporains en psychologie de l’émotion, 2010.

http://cms.unige.ch/fapse/EmotionLab/pdf/Coppin%20&%20Sander%20(2010).pdf

[ii] R. W. Picard. Affective Computing. The MIT Press, Cambridge, September 1997 https://www.pervasive.jku.at/Teaching/_2009SS/SeminarausPervasiveComputing/Begleitmaterial/Related%20Work%20(Readings)/1995_Affective%20computing_Picard.pdf

[iii] Reeves B, Nass CI. The media equation: How people treat computers, television, and new media like real people and places. Cambridge university press; 1996.

[iv] S. R. Covey. The 7 Habits of Highly Effective People. Free Press, November 2004

[v] https://mbamci.com/ia-emotionnelle-personnalisation/

[vi] Picard, R. W. “Toward Machines with Emotional Intelligence, Chapter in The science of emotional intelligence: Knowns and unknowns.” (2007).

https://affect.media.mit.edu/pdfs/07.picard-EI-chapter.pdf

[vii] https://www.bbvaopenmind.com/en/what-is-affective-computing/

[ix] https://www.affectiva.com/emotion-ai-overview/

[x] https://www.newscientist.com/article/2114900-concerns-as-face-recognition-tech-used-to-identify-criminals/

[xi] https://www.devicedaily.com/pin/apple-buys-a-startup-that-may-help-it-read-your-facial-expressions/

[xii] https://atelier.bnpparibas/prospective/article/intelligence-artificielle-emotionnelle

[xiii] https://atelier.bnpparibas/smart-city/article/l-intelligence-emotionnelle-arrive-voiture-autonome

[xiv] Harari, Y. N. Homo Deus: A brief history of tomorrow, Harvill Secker Publishers, 2015.

[xv] https://www.techsciresearch.com/report/global-affective-computing-market/1327.html

[xvi] https://www.maximizemarketresearch.com/market-report/affective-computing-market/13333/

[xvii] https://www.prnewswire.com/news-releases/global-affective-computing-market-forecast-2018-2026-300733687.html