Le 8 mai 2018 Google présentait sa dernière innovation en matière d’intelligences artificielles interactives, autrement appelées Chatbot ou encore plus récemment agents virtuels intelligents (AVI): Google Duplex. Lors de cette présentation, on a pu écouter le nouvel assistant Google prendre rendez-vous chez le coiffeur et réserver une table à un restaurant à notre place (1). Le fait le plus marquant lors de ces deux exemples est que les deux interlocuteurs ne se sont rendu compte à aucun moment qu’ils discutaient avec une intelligence artificielle, et non une personne. Comme on peut s’en douter, cette présentation a fait grand bruit, notamment suite aux avancés en termes de text-to-speech, la technologie qui permet à un ordinateur de lire des textes à voix haute. En effet, c’est en conciliant les technologies de WaveNet et de Tacotran 2 que Google Duplex arrive à ce résultat si proche de la réalité : WaveNet crée un timbre de voix réaliste en échantillonnant la voix humaine alors que Tacotran 2 permet une intonation crédible en marquant des pauses et en introduisant des disfluences telles que « hum » ou encore « heu » (2).

Cette innovation est l’une des dernières en date concernant les ChatBot ou AVI, mais les progrès technologiques ne cessent de repousser et de dépasser les limites actuelles, et cela en opérant des changements dans notre mode de vie. En effet, on peut aujourd’hui observer dans un certain nombre de maison des assistants virtuels tels que « Google Home » ou encore « Alexa ». Or suite à l’intégration croissante de ces intelligences artificielles, nous sommes en droit de nous demander quelle sera la place de ces IA dans la société de demain. Notamment, les services après-ventes, centres d’appels et autres services de ce type sont-ils voué à disparaitre ? Finalement, avec l’arrivée de telles intelligences, quelle place reste-t-il pour l’intelligence humaine

A. Le Natural Language Processing, ou comment dialoguer avec une intelligence artificielle

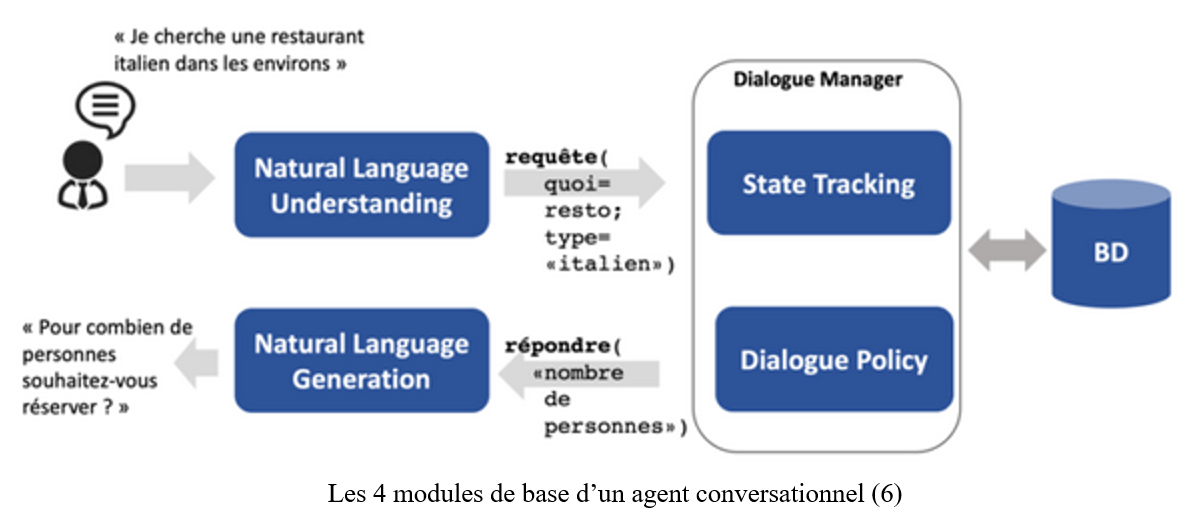

Avant toute chose, il semble important de préciser que le NLP est constitué de deux grandes composantes : le Natural Language Understanding (NLU) qui est la brique permettant la compréhension des demandes d’un utilisateur, et le Natural Language Generation qui est la brique permettant la création en instantané de réponses pour l’utilisateur (3). Or ces deux entités de la NLP utilise toute deux la même technologie, qui est d’ailleurs en pleine expansion depuis quelques années : le machine learning, et plus précisément le deep learning.

1. Des fondations technologiques basées sur une reproduction du cerveau humain

Avant toute chose il semble important de définir certains mots clés tels que machine learning ou deep learning. Le machine learning correspond au fait « d’autonomiser un ordinateur pour lui apprendre à réaliser une tâche de manière automatique grâce à des méthodes statistiques, des algorithmes, et à partir d’un certain nombre d’exemples » (4). Le deep learning quant à lui fait partie intégrante du machine learning mais a une certaine particularité : celle de « la capacité du réseau de neurones à apprendre de ses erreurs » (4).

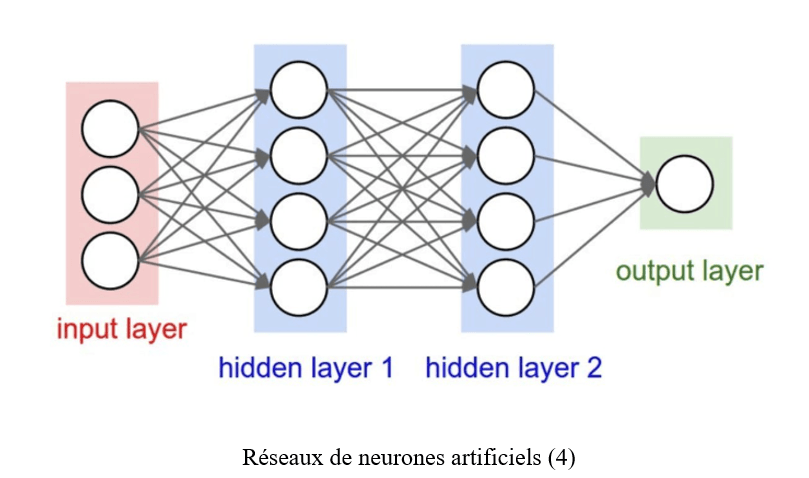

On peut très vite remarquer l’emploi du mot « neurones » lors de la définition du concept de deep learning et pour cause : les intelligences artificielles modernes s’inspirent directement du fonctionnement du cerveau humain. Autrement dit, l’intelligence artificielle actuelle est finalement une copie numérique de l’intelligence humaine. En effet c’est depuis l’émergence de la cybernétique pendant la seconde guerre mondiale que nombre de chercheurs tentent de construire des supercalculateurs en s’inspirant du cerveau humain. C’est en suivant cette voie que Frank Rosenblatt met au point en 1958 le premier réseau de neurones artificiels, directement inspiré par la morphologie de la cellule organique. Mais il est limité par les puissances de calcul du moment ainsi que par les faibles applications possibles. Il faudra attendre 2012 et 2013 pour que les réseaux de neurones fassent leur réapparition au sein des recherches sur l’intelligence artificielle avec notamment le deep learning (5)

En fait chaque couche de neurone artificielle est interconnectée, de la même façon que les différentes cellules universelles du cerveau humain. A chaque neurone constituant est affectée un coefficient et chaque donnée d’entrée va être multiplié par ce coefficient et va appliquer une certaine fonction à ce résultat. Si la donnée est positive alors le neurone va envoyer la donnée à la couche suivante et ce jusqu’à ce que la donnée atteigne la couche ultime, on aura alors notre résultat.

Finalement les intelligences artificielles de deep learning ne font que copier le fonctionnement de l’intelligence humaine, mais le font-elles mieux ou moins bien que nous ? C’est ici une question qui mérite une réponse nuancée : certaines IA font mieux que nous certaines tâches mais elles souffrent de deux lacunes essentielles : une capacité à apprendre extrêmement longue comparé à l’esprit humain et une spécificité dans les tâches qu’elles sont capable de faire. Ces deux lacunes permettent d’ailleurs à certains scientifiques de pouvoir classer les intelligences artificielles dans différentes catégories et selon différents niveaux.

On peut donc distinguer 6 classes d’intelligences artificielles : quatre niveaux pour les IA ayants des tâches spécifiques et ayants différents niveaux de « qualité » tels que sous-humain, humain, supérieur à la plupart des humains et supérieure à toute intelligence humaine. Enfin les deux dernières catégories sont celles que nous n’avons pour l’instant pas encore atteintes : « l’Artificial General Intelligence » ou IA égale ou supérieure à l’intelligence humaine pour une majorité de tâches et l’intelligence artificielle ultime, autrement appelée « singularité technologique » et qui peut correspondre aux différentes IA que l’on retrouve dans des œuvres de science-fiction tels que Terminator.

Enfin il semble important de relever un point plutôt intéressant dans les différentes classes d’intelligence artificielles : les quatre catégories d’IA que nous avons pour l’instant atteinte se définissent toute en comparaison avec l’intelligence humaine. En effet on aurait également pu attribuer des définitions de catégories plus techniques et se basant sur leur fonctionnement. Cette remarque permet finalement d’apporter une première vision du rapport entre intelligence humaine et intelligence artificielle : celle de deux intelligences en concurrence et qu’il faut comparer pour les comprendre totalement.

2. Principe et explications autour des agents conversationnels

En premier lieu il faut définir précisément ce que c’est que le NLP. On peut le définir comme suit : « le NPL consiste en un ensemble de solutions technologiques, qui permettent d’interpréter ce que souhaite faire un utilisateur et ainsi d’activer la possibilité de répondre à ses besoins » (6). Outre le NPL un agent conversationnel fonctionne grâce à d’autres modules qu’il semble important de connaître et de comprendre pour cerner leur fonctionnement.

Tout d’abord deux de ces quatre modules font partie du NLP, il s’agit du NLU et du NLG. Le Conversational State Tracking se charge quant à lui de construire l’état de la conversation, et ce grâce aux réseaux de neurones récurrents que nous avons vu précédemment. Enfin le Dialogue Policy décide de la prochaine action, réponse, à fournir selon les indications du State Tracking.

Ensuite l’agent conversationnel peut être « entrainé » par deux types d’apprentissages différents. Le premier est l’apprentissage supervisé, il demande un certain nombre de données de bonnes qualités, mais il permet d’améliorer les performances de chacun des modules : on utilise des exemples passés pour que le programme puisse apprendre de lui-même. Le second type d’apprentissage possible est l’apprentissage par renforcement, cet apprentissage vise à « construire des agents capables de prendre des décisions autonomes dans des environnements complexes ou même aléatoires. […] L’apprentissage supervisé permet à un agent d’apprendre de par sa propre expérience plutôt que d’exploiter une expérience passée » (7).

Finalement, et lorsque l’on comprend le fonctionnement de ces agents conversationnels, on est en droit de se demander si les agents conversationnels sont réellement des intelligences artificielles. En effet tout dépend de la définition que l’on donne à l’intelligence : si l’on prend la définition de Google « la faculté de connaître, de comprendre ; qualité de l’esprit qui comprend et s’adapte facilement » alors oui ce sont des agents intelligents, à contrario pour Max Tegmark l’intelligence c’est « mener à bien des objectifs complexes », on en est donc encore loin au vu de la dépendance de la machine à l’homme (8).

B. Vers des intelligences artificielles dépassant nos propres capacités ?

Le fonctionnement des agents conversationnels met en évidence plusieurs choses : les capacités d’apprentissage des programmes de compréhension du langage n’ont jamais été aussi performantes et leurs domaines d’applications ne vont cesser de croître. Mais il faut tout de même nuancer cet enthousiasme : même si leur performance ne va qu’en s’améliorant ils souffrent tout de même d’un certain nombre de limites, limites non négligeables si on veut pouvoir démocratiser leur utilisation.

1. Des limites actuelles bien trop grandes

La première et la plus grande limite dont souffrent les programmes des agents conversationnels est l’internalisation des biais lors des apprentissages supervisés. En effet comme nous l’avons expliqué précédemment, ces programmes ont besoin d’un grand nombre de données et d’entrainement avant d’être mis en relation avec un utilisateur réel. Ce ne sont d’ailleurs pas les seuls, la plupart des IA utilisant le deep learning passe par ce procédé, généralisant ainsi les conséquences à l’ensemble des secteurs professionnels. Or l’un des plus gros problèmes actuel est la non objectivité des personnes entrainant les programmes ou encore la non représentativité et la non hétérogénéité des bases de données servant à l’apprentissage : elles proviennent de notre société, elles renferment donc nos nuances, défauts et schéma de comportement. Ainsi un certain nombre de problème est déjà survenu et on retrouve aujourd’hui des avocats maitrisant les enjeux sociaux, éthiques et politiques de l’intelligence artificielle. Pour pallier à ces problèmes, certaines organisations délivrent des certificats prouvant que leur intelligence artificielle répond à des règles éthiques, on peut notamment citer ORCAA, qui vérifie chaque ligne de code de l’IA pour certifier que tout est en règle. Ces problèmes montre bien que l’intelligence artificielle peut encore s’améliorer, peut être en étant développé dans un cadre éthique institutionnalisé ? Ce sera à nos politiques de répondre à cette question.

La seconde limite que l’on pourra mettre en évidence est le manque de capacité des IA actuelles à mettre du sens derrière tout ce qu’elles accomplissent (11). En effet si l’on reprend notre cas pratique des agents conversationnels, ils répondent à toutes sortes de demandes uniquement en suivant des protocoles informatiques : un AVI avec la meilleur configuration possible peut être qualifié de « malin » mais pas d’intelligent, parce qu’il ne l’est finalement pas intrinsèquement (10).

Enfin il reste les limites de fonctionnement que nous avons précisé dans la première partie : spécialisation des tâches et apprentissage long, fastidieux et coûteux pour les développeurs.

2. Un rapport homme-machine déjà compliqué

Après avoir compris le fonctionnement et les limites des agents conversationnels nous pouvons maintenant nous pencher sur les conséquences de leur fonctionnement et de leurs différents secteurs d’application. En effet il est de notoriété publique que le progrès technologique a toujours eu de lourdes conséquences sur notre société.

Les conséquences sur notre société sont déjà présentes : automatisation des tâches, destruction et création d’emplois, augmentation de la valeur des big data, etc… En effet même si nous ne vivons pour l’instant pas dans un monde futuriste tel que certains films ou séries le dépeigne on retrouve dans notre monde des intelligences artificielles dans tous les secteurs professionnels, géographique mais aussi dans la plupart des catégories sociales. L’occupation d’un grand nombre de nos activités traditionnel par les IA pose déjà un certain nombre de problème sociaux, à commencer pendant quelques années par le remplacement d’un grand nombre d’ouvriers par des machines. Or on peut d’ores et déjà mettre en évidence un premier point : même si la machine est meilleure que nous dans certains domaines nous avons vu précédemment qu’elle souffre de deux lacunes : le temps d’apprentissage mais aussi et surtout sa spécialisation obligatoire. On peut donc finalement prévoir quels sont les emplois « à risque » et lesquels ne le sont pas. Il faut pouvoir tirer profit de notre avantage sur la machine et l’intelligence artificielle : l’intelligence humaine reste aujourd’hui supérieure à l’IA de par la diversité de ses connaissances ainsi que par sa capacité d’apprentissage rapide.

Un autre point de friction entre l’Homme et la machine se trouve dans le paysage informationnel actuel, notamment sur internet. En effet nous sommes aujourd’hui déjà influencés par les IA, nos actions étant observées, décortiquées, analysées et ensuite réutilisées pour « répondre à nos besoins » si l’on en croit les grandes entreprises numériques. L’une des conséquences de cette « influence acceptée » est l’importance croissante des données dans notre monde, et notamment des données personnelles d’utilisateurs. En effet grâce à ces données et aux IA permettant de les analyser, notamment grâce au machine et deep learning, les grandes entreprises du numériques sont en mesure d’anticiper et de proposer aux consommateurs des produits ou service avant même qu’ils en aient besoin. Ce changement et cette personnalisation du paysage informationnel de chaque individu est pourtant dangereux, Bruno Patino l’explique bien dans son livre « La civilisation du poisson rouge ». En effet pour souligner la dangerosité d’un tel changement il prend l’exemple des plateformes de streaming musical tels que Deezer ou Spotify qui « réduisent notre universalité » en rendant notre écoute confortable, c’est-à-dire en nous faisant écouter quelque chose qui nous satisfasse, de façon prévisible et individuelle. Bruno Patino cite également Eli Pariser qui met également en garde contre ce changement informationnel : « les algorithmes emprisonnent un utilisateur dans une bulle d’informations, qui l’enferme dans sa propre vision du monde et « l’endoctrine avec sa propre opinion » » (9). Les IA ont déjà une sorte de contrôle vis-à-vis de nous-même, mais uniquement parce que certains ont fait ce choix-là. A ce titre on peut aisément affirmer qu’en terme de manipulation et d’influence les IA sont passé maitre en la matière, et ont une intelligence leur permettant d’altérer la réalité des Hommes.

Conclusion

Au vu du cas des agents conversationnels intelligents et des conséquences sociétales des IA on peut établir un certain type de lien entre intelligence humaine et intelligence artificielle : un lien de complémentarité. En effet notre culture et les différentes œuvres de science-fiction nous ont toujours amené à confronter intelligence humaine et artificielle comme si l’une des deux devait absolument disparaître à terme. La réalité est bien différente, du moins pour le moment et dans un avenir proche. En effet, les intelligences artificielles ne sont actuellement que des outils, elles permettent d’améliorer notre intelligence humaine grâce à leur force de calcul et d’analyse.

De plus la question d’une super intelligence artificielle ne se pose actuellement pas puisque la question de la création de réseaux de neurones artificiels complexes ne se pose actuellement ni à court ni à moyen terme selon Jean-Claude Heudin (5). Finalement même si l’IA nous dépasse dans certains domaines, l’intelligence humaine multiforme, émotionnelle et empathique nous permet de faire des choix en connaissances des causes, des conséquences, du contexte et de l’environnement dans lequel nous évoluons, chose impossible pour l’intelligence artificielle.

Par Victor Munter, promotion 2019-2020 du Master 2 IESCI

Bibliographie

Références principales

(5) Heudin, Jean-Claude. « Intelligence artificielle et intelligence humaine », Futuribles, vol. 428, no. 1, 2019, pp. 93-105. URL: https://www.cairn.info/revue-futuribles-2019-1-page-93.htm

(7) https://weave.eu/lart-difficile-de-la-conversation-artificielle/

(9) Bruno Patino, « La civilisation du poisson rouge. Petit traité sur le marché de l’attention », Grasset, Paris, 2019

(12) Bellier, Jean-Pierre. « Pensée binaire, pensée complexe », Futuribles, vol. 433, no. 6, 2019, pp. 19-26. URL: https://www.cairn.info/revue-futuribles-2019-6-page-19.htm?contenu=article

Autres sources

(1) https://www.youtube.com/watch?v=D5VN56jQMWM

(2) https://www.journaldunet.com/solutions/dsi/1417159-les-dessous-techniques-de-google-duplex/

(3) https://medium.com/@lola.com/nlp-vs-nlu-whats-the-difference-d91c06780992

(4) https://medium.com/jedha/les-applications-du-deep-learning-d674483d44af

(8) http://www.vizir.co/chatbot/chatbot-intelligence-artificielle/

(10) https://solutions.lesechos.fr/tech/c/les-chatbots-sont-ils-stupides-9012/

(11) https://theconversation.com/lia-et-le-langage-comment-capturer-ce-qui-fait-sens-105897