La date du 11 mai 1997 marque un tournant dans l’histoire de l’Intelligence Artificielle. Pour la première fois, dans un match qui oppose le champion du monde de jeu d’échecs Gary Kasparov au supercalculateur d’IBM Deeper Blue, la machine sort victorieuse.

Il faudra attendre presque vingt ans pour qu’un exploit similaire se reproduise. Le 15 mars 2016, c’est Lee Sedol, champion du monde du jeu de go, qui s’incline face à AlphaGo, un algorithme développé par la société Deep Thought, elle-même propriété de Google.

Cette progression de l’Intelligence Artificielle (IA) a été largement commentée car la complexité du jeu de go est bien plus élevée que celle des échecs, tant au niveau des règles que du nombre de positions possibles, à tel point que les experts en IA aussi bien qu’en jeu de go ne pensaient pas qu’une machine serait capable de mettre en défaut l’Homme avant une dizaine d’années.

Mais c’est surtout la technologie sous-jacente à cette victoire qui est en rupture avec ce qu’on pouvait auparavant trouver dans le domaine de l’Intelligence Artificielle : AlphaGo est un algorithme reposant sur des réseaux de neurones artificiels permettant un apprentissage profond (ou « deep learning » en anglais). Cela veut concrètement dire que plutôt que de bénéficier d’une base de données fixe à laquelle l’algorithme aurait recourt pour calculer les probabilités des meilleurs coups possibles en fonction d’une situation donnée, l’algorithme s’améliore au fil des parties qu’il effectue pour intégrer les « bons coups » et apprendre de ses erreurs.

Ainsi, les concepteurs d’AlphaGo ne lui ont pas appris à jouer au jeu de go, ou de manière très rudimentaire ; c’est le jeu qui s’est appris lui-même à jouer au fur et à mesure des parties auxquelles il a été confronté, jusqu’à parvenir dépasser le meilleur joueur humain de go.

Pour certains observateurs, ces progrès de l’IA sont à replacer dans un contexte plus large, celui des NBIC (pour Nanotechnologies, Biotechnologies, technologies de l’Information et sciences Cognitives) et sont la preuve de l’existence d’une « convergence » de ces NBIC. Qu’est-ce que cela signifie ? c’est ce que cet article cherchera à expliciter avec, en première partie un détail sur ce que couvre le terme de « NBIC », avant de s’intéresser aux signes d’une convergence de ces technologies dans une seconde partie.

NBIC – Qu’est-ce que c’est ?

1. Les nanotechnologies.

Les nanotechnologies sont littéralement les « technologies du tout petit ». Elles tirent leur nom du nanomètre, l’unité de mesure de longueur qui représente un milliardième de mètre.

L’émergence des nanotechnologies fut possible grâce à l’invention en 1981 par des ingénieurs d’IBM du microscope à effet de tunnel, le premier microscope donnant accès au « nanomonde » et permettant d’observer différents matériaux à l’échelle nanométrique.

La recherche scientifique étant maintenant possible à l’échelle nanométrique, elle va alors se développer. Dans ce développement, elle va bénéficier d’un « coup de pouce » grâce à un étudiant du Massachusetts Institute of Technology, Eric Drexler, qui va mettre les nanotechnologies sur le devant de la scène.

En 1986 est publié Engines of Creation : The Coming Era of Nanotechnology, un ouvrage dans lequel Drexler imagine les transformations de nos sociétés grâce à l’avènement des nanotechnologies dans des domaines tels que la médecine, l’informatique ou la production de matériaux. Cet ouvrage, à mi-chemin entre la publication scientifique et le récit de science-fiction va participer auprès du grand public et des décideurs politiques à une prise de conscience autours des enjeux que représentent ces nanotechnologies et va nourrir les décisions d’investissements publics massifs en Europe, aux Etats-Unis et au Japon à la fin des années 1990 et au début des années 2000.

Aujourd’hui en 2017, les nanotechnologies sont une réalité, mais une réalité qui recouvre deux sens.

Le premier décrit le changement de propriétés que connaissent certains matériaux lorsqu’ils sont transposés à l’échelle nanométrique, qualifié d’effet quantique. Les nanoparticules d’or par exemple n’ont pas la même couleur, pas le même point de fusion ni la même conductivité que l’or tel que nous le connaissons. De la même manière, les nanoparticules d’argent possèdent des propriétés biocides qui n’existent pas à l’échelle micro ou macro, et qui sont aujourd’hui intégrées dans les textiles pour obtenir par exemple des sous-vêtements sans odeur.

Ces effets quantiques étant largement méconnus, une grande partie de la recherche aujourd’hui se concentre sur leur découverte, et sur la création de structures et d’architectures moléculaires permettant d’exploiter ces effets quantiques et de les intégrer à de nouveaux matériaux et nouveaux produits.

Le second s’attache au travail sur les matériaux à l’échelle nanométrique sans pour autant rechercher des effets quantiques. L’exemple le plus connu de ce type de nanotechnologie est le nanotube de carbone dont les propriétés physiques exceptionnelles permettent un grand nombre d’applications industrielles. Les nanotechnologies permettent alors un travail plus fin sur les matériaux afin d’en maximiser les propriétés initiales, comme c’est le cas en ce qui concerne la lithographie électronique, permettant une gravure plus fine des microprocesseurs et donc des performances en hausse chaque année.

2. Les biotechnologies.

Les biotechnologies sont, selon l’OCDE, « l’application à des organismes vivants des principes scientifiques et de l’ingénierie à la transformation de matériaux vivants ou non-vivants aux fins de la production de connaissances, de biens et de services. ».

A l’inverse des nanotechnologies, les biotechnologies sont loin d’être nouvelles : la fermentation alcoolique, de par l’utilisation de levures pour transformer le sucre en alcool, est une forme de biotechnologie très ancienne.

Aujourd’hui, les biotechnologies se divisent en cinq grands sous-domaines :

- Les biotechnologies vertes : il s’agit des biotechnologies qui s’intéressent à l’agriculture, à l’élevage ou encore à l’agroalimentaire. Une des réalisations des biotechnologies vertes est la création des organismes génétiquement modifiés, les OGM.

- Les biotechnologies bleues : il s’agit des biotechnologies explorant et exploitant les ressources marines en vue de concevoir de nouveaux produits.

- Les biotechnologies rouges : elles concernent les domaines de la santé, du médicament et du diagnostic. Elles servent la création de nouveaux tissus ou l’élaboration de nouveaux procédés moléculaires ou génétiques à des fins thérapeutiques. Un exemple de biotechnologie rouge communément rencontrée est le vaccin.

- Les biotechnologies jaunes : ce sont les biotechnologies à finalités environnementales, servant à résoudre des problèmes environnementaux tels que la pollution des sols ou des eaux.

- Les biotechnologies blanches : il s’agit de l’utilisation industrielle des biotechnologies dans le but de créer de nouveaux procédés pour produire de la bioénergie ou de nouveau matériaux tels que des polymères biodégradables.

3. Les technologies de l’information.

Les technologies de l’information, plus communément appelées « informatique », sont maintenant un élément bien ancré dans nos vies, tant professionnelles que privées. L’usage des technologies de l’information est aujourd’hui omniprésent, que ce soit par l’utilisation d’ordinateurs personnels ou de smartphones, par la progression des supports numériques qui remplacent les supports physiques dans nombre de domaines tels que la musique ou le cinéma, mais aussi car nombre de biens physiques s’enrichissent de caractéristiques numériques en plus de leurs fonctions usuelles : ordinateurs de bords dans les véhicules, ou plus récemment, développement des objets connectées et de « l’Internet des objets ».

Si vous lisez cet article, il est fort probable que vous soyez familier avec ce type de technologie. L’exergue sera alors plutôt placé sur deux éléments qui peuvent expliquer cette invasion progressive du numérique.

Le premier est l’existence de la loi de Moore : selon Gordon. E. Moore, tous les 18 à 24 mois, la puissance des microprocesseurs double. Cette loi s’est montrée stable dans le temps comme on peut l’observer ici (Source – sur les données d’Intel).

Cette hausse continue de la puissance des microprocesseurs implique qu’avec le temps, les champs d’applications des technologies de l’information s’étendent à de plus en plus de domaines.

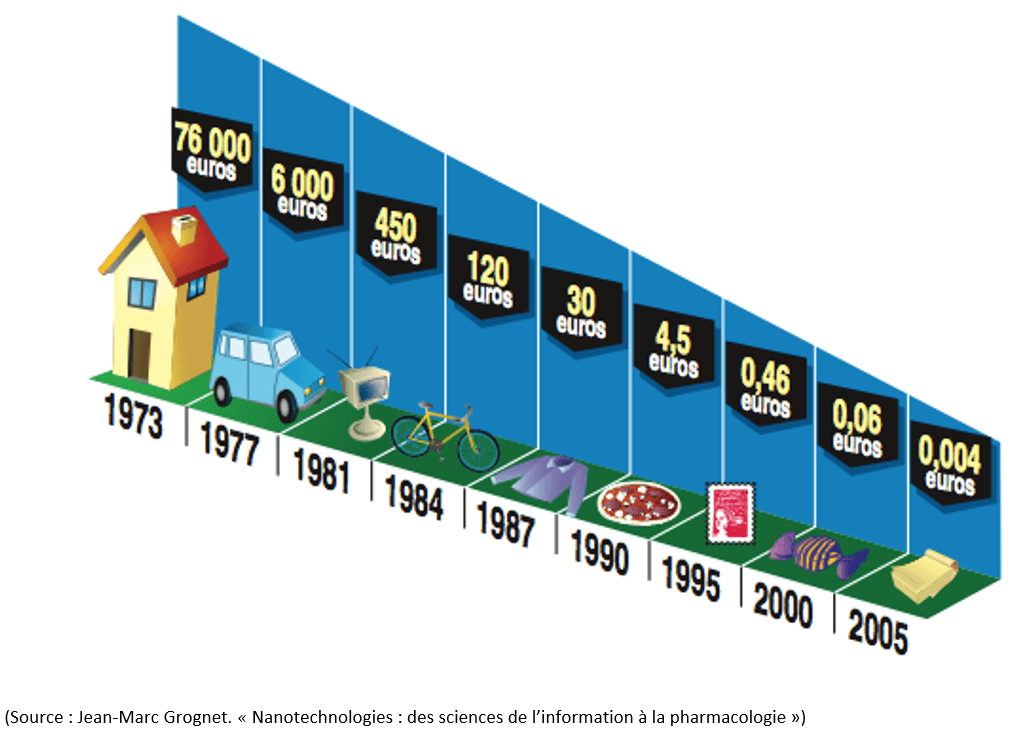

Le second élément est la baisse continue du prix du transistors. En 1973 selon le Ministère de la recherche, un million de transistors valaient environ 76 000 euros. En 2005, le même nombre de transistors ne valait plus que 0,004 euros ; un prix inférieur à celui d’une feuille de papier !

Avec une puissance croissante pour toujours plus de nouvelles applications, et un prix en constante diminution, la démocratisation des technologies de l’information est un phénomène bien réel et aisément appréhendable.

4. Les sciences cognitives.

Les sciences cognitives sont les sciences qui s’intéressent à la cognition, elle-même définie par le dictionnaire Larousse comme étant la « faculté de connaitre », et de manière plus explicite « l’ensemble des structures et activités psychologiques dont la fonction est la connaissance, par opposition aux domaines de l’affectivité ».

Les sciences cognitives se trouvent au carrefour de plusieurs disciplines : la philosophie, la psychologie, la linguistique, les neurosciences, l’anthropologie et l’intelligence artificielle.

Du fait de cette transdisciplinarité des sciences cognitives, les questions abordées par ces sciences sont variées. Il peut s’agir d’interrogations sur la manière qu’à le cerveau de façonner le langage, et l’action qu’effectue en retour sur le cerveau le langage. Il peut s’agir d’une réflexion sur le rôle joué par les différentes aires du cerveau sur les capacités cognitives d’un individu. Il peut s’agir de questions autour de l’impact des neurotransmetteurs sur les comportements humains. Il peut s’agir de réflexions plus philosophiques sur la manière dont la conscience émerge des connexions neuronales, ou sur la réalité que nous semblons tous partager et qui est pourtant le fruit d’une interprétation individuelle des signaux qui sont transmis de nos organes sensoriels à nos cerveaux. Enfin, il s’agit aussi de replacer la pensée humaine en rapport avec la machine comme l’ont fait certains penseurs tels qu’Alan Turing, avec la machine de Turing ou encore le test de Turing.

Les sciences cognitives cherchent alors à décrypter, à comprendre les mécanismes sous-jacents aux fonctions intellectuelles des êtres humains.

La convergence des NBIC

Lorsqu’on parle des technologies NBIC, la « convergence » de ces technologies est un terme qui revient fréquemment. Il s’explique par le fait qu’il apparait qu’au fur et à mesure que ces technologies NBIC se développent, une analogie entre systèmes vivants et artificiels apparait. Cette analogie est possible grâce aux progrès des sciences cognitives, des biotechnologies et de l’informatique, mais aussi grâce à la concrétisation des nanotechnologies.

Mais comment cette convergence se manifeste-t-elle ?

Un premier exemple est l’utilisation de réseaux de neurones artificiels dont le fonctionnement est inspiré des réseaux de neurones biologiques. Le but de ces réseaux de neurones artificiels est de produire un système en plusieurs couches dont la finalité est la reconnaissance d’éléments donnés : lignes spécifiques d’une partie du visage, formes d’un panneau de signalisation, reconnaissance du son d’une voyelle ou d’une consonne prononcée …

Ces éléments reconnus par les réseaux de neurones artificiels vont ensuite être interprétés et combinés par des algorithmes qui vont chercher à donner un sens global et des éléments individuels : le principe de fonctionnement de ces algorithmes est directement tiré de l’enseignement des sciences cognitives sur le cerveau.

Comme indiqué en introduction, ces réseaux de neurones artificiels ont été utilisés par l’algorithme AlphaGo, mais ils ont aussi des applications beaucoup plus proches de nos vies quotidiennes. En septembre 2017, lors de la présentation des nouveaux iPhone 8 et X de la firme Apple, il a été annoncé que ces nouveaux téléphonse intégreraient un « réseau neuronal » afin de rendre l’IA embarquée de ces téléphones plus performante, mais aussi d’amorcer l’adaptation du hardware à cette convergence des NBIC.

Un autre domaine dans lequel les NBIC convergent est dans celui de la manipulation de l’ADN et de la génétique. Un brin d’ADN mesurant 3 à 4 nanomètres, les nanotechnologies rendent la manipulation des brins d’ADN désormais possible.

Ces manipulations passent par le biais de l’édition du code génétique contenu par les brins d’ADN de la même manière que l’on écrirait du code informatique pour créer un logiciel. C’est en partie ce qu’a pu réaliser Craig Venter en 2007 en remplaçant une partie de l’ADN d’une cellule par de l’ADN artificiel créé en laboratoire.

De par cette similarité entre code informatique et code génétique supporté par l’ADN, des recherches existent aujourd’hui pour utiliser l’ADN comme support de données numériques, des recherches auxquelles les GAFA s’intéressent car elles permettent un gain de place considérable et une stabilité dans le temps qui n’existe pas avec les moyens de stockages utilisés actuellement.

Mais là où la convergence des NBIC est peut-être la plus flagrante, c’est dans ce qu’elle permet et permettra dans le domaine de la médecine.

Grâce à l’édition de l’ADN et son intégration possible dans des cellules vivantes, certains imaginent déjà des traitements à base de cellules artificielles ayant pour but d’éradiquer les symptômes de certaines maladies, voir d’éradiquer la maladie elle-même.

Un pan de la recherche s’intéresse aussi aux nano médicaments, des médicaments qui iront agir de manière localisée directement à l’intérieur de cellules de certains organes plutôt que de se diffuser de manière indifférenciée dans l’ensemble de l’organisme. Certains de ces médicaments sont déjà une réalité comme dans le traitement du cancer, où des nanoparticules d’or sont injectées dans des cellules, permettant alors de détruire ces cellules par radiothérapie.

D’autres recherches encore s’intéressent à un interfaçage possible entre l’artificiel et le vivant : créer des ajouts artificiels à certains organes pour compenser une mal-fonction ou un défaut, par exemple, une rétine artificielle pour les malvoyants et aveugles conçue en nanomatériaux réactif à la lumière qui serait ensuite mise en connexion avec le nerf optique par le biais de la nanotechnologie. Si ces recherches visent à corriger un défaut existant, d’autres en viennent à fantasmer sur l’idée d’un être humain « augmenté » dans lequel il serait possible de remplacer certains organes ou certaines fonctions par des fonctions artificielles créées en laboratoire : greffe de processeurs et de neurones artificiels dans le cerveau, remplacement de certaines cellules par d’autres insensibles au vieillissement …

Conclusion :

Les NBIC sont un domaine en pleine expansion et porteuses de nombreux espoirs en termes de développements futurs. L’IA commence à être accessible au grand public et promet d’être un allié de taille pour la recherche scientifique en automatisant des étapes qui demandent actuellement aux chercheurs beaucoup de temps et d’énergie. Les nano médicaments portent en eux les espoirs d’une moins grande vulnérabilité aux maladies et d’un allongement de la durée de vie en bonne santé. Les nanotechnologies pourraient aider à résoudre certains problèmes environnementaux liés à la pollution des sols.

Mais chez les développeurs de ces NBIC, ces attentes semblent se rapprocher de la science-fiction avec de développement d’une pensée « transhumaniste » où grâce aux NBIC, l’être humain pourrait transcender sa propre existence. C’est un courant de pensée qui existe notamment chez les dirigeants de Google qui espèrent d’ici 2045 pouvoir « tuer la mort », mais qui est remis en question par nombre de chercheurs dans le domaine en étant qualifié « d’irréaliste » … du moins dans un futur proche.

Si les NBIC nourrissent autant de fantasmes, c’est finalement que malgré les progrès accomplis, elles ne sont pas encore assez matures et suffisamment explorées pour qu’on puisse réellement savoir où elles mènent. Le terme de « convergence » est alors assez révélateur car il semble pointer que ces technologies se rapprochent les unes des autres sans révéler la direction vers laquelle elles nous dirigent.

Reste qu’au-delà des attentes, il y a aussi des craintes : impact des nanomatériaux sur la santé et l’environnement, impact de l’intelligence artificielle sur le marché du travail dont l’équilibre est précaire dans de nombreux pays, question des inégalités d’accès aux traitements de pointe et donc coûteux ou encore questions éthiques autours de la modification génétique du vivant, ces NBIC sont aussi annonciatrices de changement radicaux dans un monde déjà bien incertain.

Par Benoit Fournier, promotion 2017-2018 du M2 IESCI

Bibliographie :

Auplat, Claire, et Aurélie Delemarle. « Mieux comprendre les nouvelles opportunités liées aux nanotechnologies », Entreprendre & Innover, vol. 16, no. 4, 2012, pp. 64-77.

Benoit-Browaeys, Dorothée. « Sciences : nanotechnologies et mégadéfis », Alternatives économiques, vol. 237, no. 6, 2005.

Cayla, David. Cours d’ « Economy of information and knowledge », 2016.

Editorial, « the future of nanotechnolgies », Technovation, vol. 32, 2012, pp. 157–160.

Jean-Marc Grognet. « Nanotechnologies : des sciences de l’information à la pharmacologie », Thérapie, vol. 63, no.1, 2007, pp. 1-9.

Jean-Yves Bottero, Jean-Marc Grognet, Louis Laurent, « Nanotechnologies : promesses et débats », Innovation, Éco-conception et innovation responsable, 2010.

Le Gall, Philippe. Cours de « méthodologie de recherche », 2017.

Maldamé, Jean-Michel. « Faut-il avoir peur des sciences cognitives ? », Études, vol. tome 396, no. 1, 2002, pp. 51-62.

Webographie :

https://www.lebigdata.fr/adn-synthetique-lavenir-stockage-de-donnees

https://deepmind.com/research/alphago/

http://www.astrosurf.com/luxorion/loi-moore.htm

https://www.ted.com/talks/ray_kurzweil_get_ready_for_hybrid_thinking